“RAG vs LLM, 인공지능 모델의 차이점과 활용법 완벽 정리!”

요즘 인공지능 이야기 속에서 자주 등장하는 단어가 있습니다. 바로 RAG입니다. RAG는 Retrieval-Augmented Generation의 약자로, 기존에 많이 알려진 LLM, 즉 대규모 언어 모델과는 구조적으로 다른 AI 모델입니다. 그렇다면 이 두 모델은 어떤 점에서 다르고, 각각 어떤 장점이 있을까요?

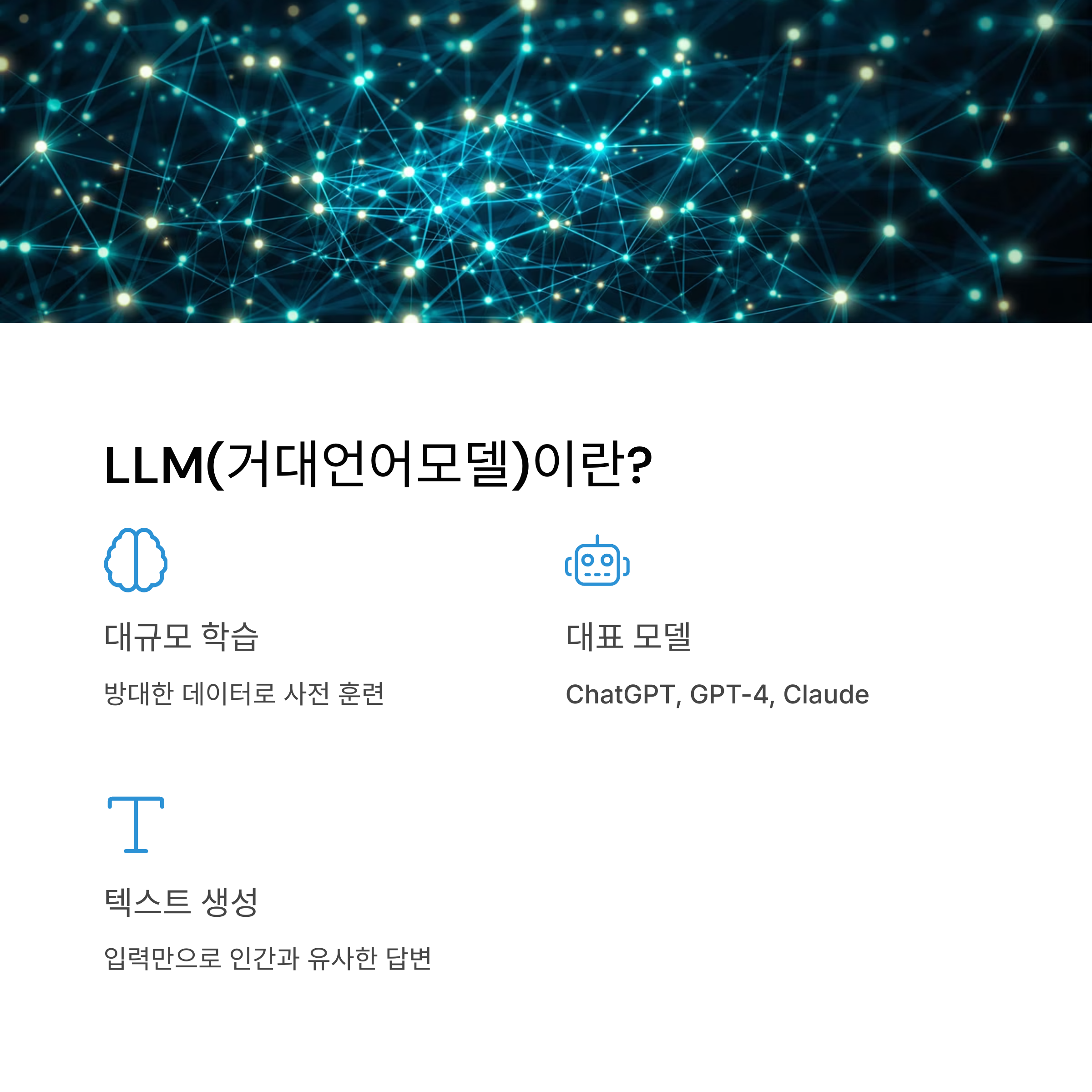

먼저 LLM 모델부터 살펴보겠습니다. LLM은 대규모 텍스트 데이터를 기반으로 학습된 모델로, GPT 시리즈나 BERT, Claude 등이 여기에 속합니다. 이 모델들은 한 번 훈련을 마치면, 그 안에 들어있는 지식만을 가지고 답을 생성합니다. 예를 들어 GPT는 2023년까지의 정보를 기억하고 있지만, 그 이후의 일은 따로 학습하지 않는 이상 알 수 없습니다. 즉, LLM은 '기억 기반'의 AI 모델이라 할 수 있습니다.

반면 RAG 모델은 조금 다릅니다. RAG는 훈련된 모델 내부의 정보뿐 아니라, 외부 데이터베이스나 문서를 검색해 그 내용을 참고하여 답을 생성합니다. 예를 들어 사용자가 "2025년 최신 AI 기술"에 대해 묻는다면, RAG는 실시간으로 외부 문서를 찾아본 뒤, 그 정보를 바탕으로 응답합니다. 즉, '검색 기반'의 AI라고 이해하면 됩니다.

이 두 모델은 구조적으로도 차이가 큽니다. LLM은 질문을 받으면 바로 내부 지식을 바탕으로 문장을 생성합니다. 하지만 RAG는 질문을 받은 뒤 먼저 관련 문서를 검색하고, 그 결과를 요약하고, 마지막으로 문장을 생성합니다. 단계를 나눠 생각하는 셈입니다. 그 결과, RAG는 최신 정보나 전문적인 자료에 기반한 답변을 할 수 있다는 장점이 있습니다.

한 가지 예를 들어보겠습니다. 같은 질문인 "최신 AI 검색 엔진의 특징은?"이라는 질문을 LLM과 RAG에 동시에 물어보면, LLM은 훈련 시점까지의 AI 기술 트렌드를 바탕으로 일반적인 정보를 제공합니다. 반면 RAG는 2025년 기준 최신 논문이나 기술 블로그를 참고해서, 지금 이 시점의 기술 흐름을 반영한 정확한 답변을 제시합니다.

이처럼 두 모델은 쓰임새가 다릅니다. 정형화된 정보나 기본 개념을 설명할 때는 LLM이 빠르고 효율적입니다. 하지만 최신 정보, 혹은 외부 자료를 기반으로 정밀한 설명이 필요한 경우에는 RAG가 훨씬 효과적입니다.

결론적으로 정리하면, LLM은 지식을 '기억'하는 AI, RAG는 지식을 '찾아서 알려주는' AI입니다. 요즘처럼 정보가 빠르게 변하는 시대에는 이 두 모델을 상황에 따라 잘 조합해서 사용하는 것이 중요합니다.

AI 기술이 어렵다고 느껴지셨다면, 이렇게 비교해보세요. 기억력 좋은 친구와 검색 잘하는 친구, 누구에게 어떤 질문을 할지를 떠올리는 것과 비슷합니다.

'관심정보' 카테고리의 다른 글

| 이중효과의 원리: 선한 의도와 해악적 결과 사이의 도덕적 딜레마 (0) | 2025.04.28 |

|---|---|

| 목표에 의한 관리(MBO)로 조직 성과를 폭발시키는 방법 (1) | 2025.04.27 |

| 락토프리 우유가 달게 느껴지는 과학적 이유 (0) | 2025.04.26 |

| 한국의 장수말벌, 왜 미국에선 살인말벌이 되었을까? (3) | 2025.04.25 |

| 삼겹살엔 소주일까 맥주일까? (1) | 2025.04.23 |